총장의 메시지 56

방 안의 코끼리, AI와 상생하는 법

‘The elephant in the room.’

모두가 문제인 걸 알고는 있지만, 누구도 이야기하고 싶지 않은 현상을 일컫는 이 말은 우화를 즐겼던 러시아의 시인 이반 크릴로프(Ivan Krylov)가 1914년 쓴 <호기심 많은 사람 The Inquisitive Man>에서 유래했습니다. 자연사 박물관에 간 한 남자가 다양한 전시물을 꼼꼼히 관찰하면서도 방 한가운데 전시된 코끼리는 보지 못한다는 얘기입니다. 이걸 1959년 NYT가 당시 심각한 교육재정의 문제를 거실에 있는 코끼리에 비유하면서 보편적인 용어가 되었습니다. 불편한 현실, 부정적인 정보를 일단 외면하려는 행동은 위험에 처했을 때 빠른 다리로 위험을 벗어나기보다는 머리를 땅에 처박는 타조에 비유해 ‘타조효과(ostrich effect)’라고도 합니다. 불안과 스트레스를 유발하는 정보나 상황을 의도적으로 무시하는 인지적 편향이라는 점에선 똑같습니다.

지금은 디지털 대전환의 시대. 삶의 곳곳에서 종전의 패러다임이 변하고 있습니다. 그게 우리를 종종 당혹스럽게 합니다. 우리 자신도 이제는 변해야 하기 때문입니다. 인공지능(AI)의 시대로 접어들면서 미래 사회는 AI를 ‘활용’해 탁월한 성과를 내는 사람들과 AI로 ‘대체’되어 살아남지 못한 사람들로 양분될 거라는 게 전문가들의 공통된 견해입니다. 그렇다고 AI에 전적으로 의지하고 따를 수는 없는 일. 인공지능의 판단에 내 생각이 더해져야만 합니다. 여기엔 흥미 있는 실험이 있습니다(BCG Report, “How People Can Create and Destroy Value with Generative AI”, 2023). 보스톤컨설팅그룹(BCG)은 하버드대학교와 MIT 등 교수들의 참여로 전 세계 750명 이상의 자사 컨설턴트 표본을 두 그룹으로 나누었습니다. 한 그룹은 종전의 방식대로, 다른 그룹은 생성형 AI GPT-4를 사용토록 했습니다. 그리고 각각 창의적인 과제, 분석 과제, 글쓰기 및 마케팅 과제, 설득력을 발휘하는 과제들을 수행토록 한 결과, 두 그룹 간에는 예상대로 성과에 큰 차이가 나타났습니다. AI를 사용한 컨설턴트의 90% 이상이 더 빨리 과제를 완수했고, 더 창의적이었으며, 문서와 문구가 더 훌륭했고, 분석적인 능력이 더 뛰어났습니다. 그런데 흥미로운 점이 발견되었습니다. 이들은 과제를 하면서 AI의 도움을 받을 것으로 기대했지만, 실제론 AI가 대부분의 일을 한 것으로 확인되었습니다. 주어진 문제를 그대로 AI로 물어봤고, AI가 대답한 내용을 편집조차 없이 그대로 사용했던 겁니다. AI를 처음 사용할 때 반복적으로 나타나는 위험입니다. 이는 우리 자신을 불필요한 존재로 만들 위험도 있지만, AI에 지나치게 의존하는 것도 위험한 일입니다. BCG는 그래서 그 위험을 실증해 봤습니다. AI가 정답을 낼 수 없도록 들쭉날쭉하고 정교하게 과제를 설계했습니다. 물론 ‘전능한’ AI가 할 수 없는 과제를 찾기란 쉽지 않은 일. 그러나 오해하기 쉬운 데이터, 까다로운 통계적 요인을 결합해 마침내 AI가 풀기 어려운 비즈니스 영역의 과제를 고안했습니다. 실험 결과는 앞의 이전과 반대로 나타났습니다. AI의 도움을 받지 않은 그룹은 정답률이 84%였지만, AI의 도움을 받은 그룹은 오히려 정답률이 60∼70%에 그쳐 23%의 유의적인 차이가 나타났습니다. AI를 너무 믿는 게 문제였습니다.

또 다른 실험. 펜실베이니아대학교 와튼스쿨(Wharton School of the UPenn)의 연구진은 채용담당자 181명 표본을 대상으로 까다로운 과제를 내주었습니다. 44개의 입사지원서를 수학 실력 기준으로 평가하는 문제. 그런데 각각의 지원서에는 일반 역량 지표인 국제 시험점수만 있을 뿐, 수학과 관련된 점수는 명시되지 않았습니다. 그리고 두 그룹으로 나누어 한쪽은 성능이 뛰어난 AI, 다른 쪽은 성능이 떨어지는 AI를 제공했습니다. 실험 결과, 성능이 뛰어난 AI를 사용한 그룹의 성과가 오히려 상대 그룹보다 낮았습니다. 뛰어난 AI를 사용한 쪽은 이력서를 검토하는데 AI의 의견을 맹목적으로 따랐던 반면, 성능 낮은 AI를 사용한 쪽은 더 주의 깊고 비판적이며, 시간이 지날수록 AI와 상호작용하는 능력은 물론 자신의 기술까지 향상되었습니다. BCG의 연구와 마찬가지로 이 실험도 AI를 너무 믿어선 안 된다는 걸 시사합니다. ‘만능의 AI’를 믿고 운전석에서 잠드는 순간 실수하기 쉽다는 얘기입니다.

세상이 온통 디지털로 바뀌면서 TV, 신문처럼 전통 매체의 영향력은 줄고 페이스북, 트위터, 유튜브 등 SNS의 사용이 늘었습니다. 빅데이터 분석으로 실시간 검색어 순위에 오르면 대중의 관심이 증폭되어 여론이 바뀝니다. 어떤 알고리즘은 쓰는가에 따라 선택과 화면의 배치가 달라지고, 다른 정보는 아예 배제되어 존재 자체를 모르고 자신의 신념만을 강화해 나가는 게 문제입니다. 사람의 생각보다는 시스템과 알고리즘의 지배를 받아 생기는 이 왜곡은 이용자에게 확증편향을 갖도록 합니다. 광고 수익을 겨냥한 SNS는 알고리즘을 이용해 사용자마다 좋아할 만한 콘텐츠를 골라 제공하는 걸 ‘개인화된 정보 서비스’라고 하지만, 여기엔 심각한 편향성의 문제가 도사리고 있습니다.

AI가 생성한 가짜 정보들을 SNS가 퍼 나르지만, 대처하기는 쉽지 않습니다. AI가 세상에 선보인 지 한 달 만에 튜링 테스트(Turing Test)를 모두 통과했습니다. 컴퓨터가 인간을 속여 자신을 인간이라고 믿게 할 수 있는지를 알아보는 테스트 얘기입니다. 변호사 시험과 신경외과 전문의 자격시험처럼 어려운 시험에선 사람보다 높은 점수도 획득했습니다. “실제로 AI와 대화를 나누었을 때, 내가 쓴 적도 없는 논문을 AI가 만들어 내서 인용하기도 했다. 그 내용이 너무나 그럴듯해서 그게 진짜인지 확인하기 위해 구글 검색을 해야만 했다. 나도 내 자신에 대한 튜링 테스트에서 실패한 셈이다.” 베스트셀러 <듀얼 브레인>의 저자 이선 몰릭(Ethan Mollick)이 AI가 만드는 허구의 위험성을 가장 극명하게 표현한 부분입니다(132쪽). 얼마나 잘나고 똑똑하고 판단력이 좋은지 상관없이 우리 모두 AI를 전적으로 믿는 걸 경계해야 합니다. 이제는 인간의 생각까지 조종하는 AI 알고리즘의 왜곡이 우리 일상에서 방 안의 코끼리처럼 다가왔습니다.

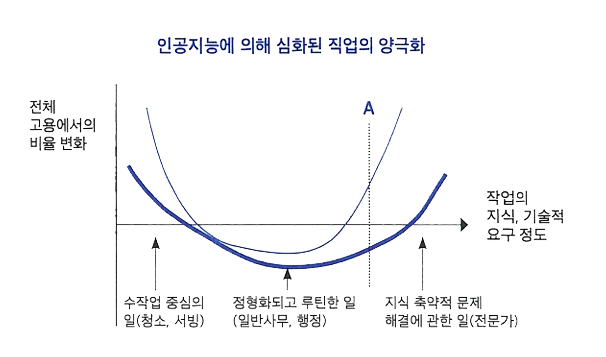

* 두꺼운 U자 형태의 그래프는 2000년대 이전에는 인공지능에 대체될 수 없던 직업군들이 자동화되며 심화된 양극화를 보여준다.

(이준기, AI로 경영하라(2022))

디지털 전환이 가져올 미래의 일자리 혁명은 우리의 삶을 얼마나 바꿀까. 기술 진보가 가속될 때 느끼는 두려움은 19C 초 영국에서 러다이트운동까지 했던 산업혁명의 결과에 답이 있습니다. 당시에는 기계가 인간의 일자리를 모두 빼앗고 노동자들이 길거리로 나앉을 걸로 생각했지만, 산업혁명은 사라진 일자리보다 훨씬 많은 일자리를 만들어 냈다는 걸 알아야 합니다. “우리는 단기적으로 기술의 영향을 과대평가하고, 장기적으로 그걸 과소평가하는 경향이 있다.” 미래학자의 이름을 딴 ‘아마라의 법칙(Amara’s law)’입니다. 장기적인 미래는 불확실합니다. 현재로선 차세대 AI가 등장하면 어떤 일이 일어날지 정확히 말할 수 있는 사람은 없습니다. 분명한 건 AI에겐 생각도 상식도 없다는 사실입니다. 상관관계에 반응해 계산만을 합니다. 인간처럼 배우는 게 아니라 수많은 데이터 속에서 규칙을 통계적으로 추론하는 존재일 뿐 나를 대신해 결정해 주는 일은 없습니다. 좋은 쪽으로든 나쁜 쪽으로든 앞으로 일어날 일에 대한 결정권은 자신에게 있습니다. 대학들이 전통적인 학과 간의 벽을 허물고 학사 구조를 융합 방식으로 전환한 데에도 이러한 시대적 변화가 자리하고 있습니다. 디지털 혁명이 들여온 코끼리를 애써 외면해선 안 됩니다. 우리 학생들이 복수의 전공 트랙으로 사고(思考)의 폭을 넓혀야 하는 이유도 여기에 있습니다. AI와 어떻게 공존하고, 누가 기계와의 경쟁에서 살아남을까. 이 궁금증에 도움이 될만한 책을 권합니다.

<총장의 메시지>

-[총장의 메시지_55] 바깥의 세상은 넓고 기회도 많습니다.-[총장의 메시지_54] 작심삼일(作心三日)의 함정

-[총장의 메시지_53] 인생을 바꾸는 고독의 힘

-[총장의 메시지_52] 인간 중심의 디지털 전환, 제5차 산업혁명

-[총장의 메시지_51] 전공자율선택제, 아메바 경영!